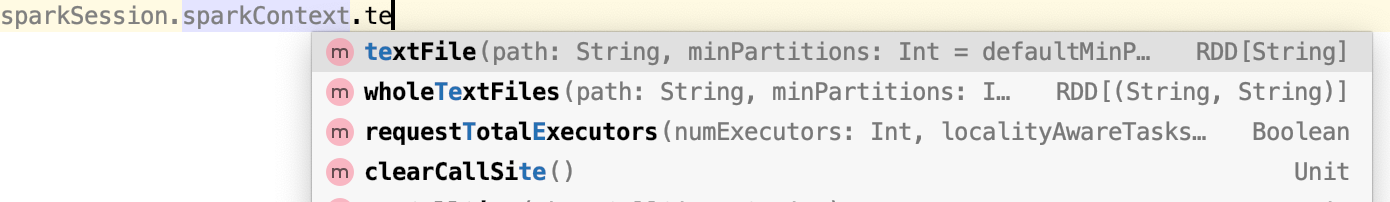

SparkSession 에서 read를 하게 되면 DataFrame, Dataset으로 생성할 수 있고, RDD로 데이터를 생성하려면 SparkSession.sparkContext를 사용해서 생성해야한다.

'BackEnd > Spark' 카테고리의 다른 글

| [Spark]Spark에서 서버의 메모리보다 더 큰 데이터를 불러와서 작업을 할수 있는데 어떻게 할까 ? (0) | 2020.03.22 |

|---|---|

| [Spark]Apache Spark 란? 특징 , 왜 쓸까? (0) | 2020.03.22 |

| [Spark] GroupByKey, ReduceByKey 차이 (PairRDD) (0) | 2020.03.18 |

| Spark Directed acyclic graph, lineage (0) | 2020.03.17 |

| SparkSession, SparkContext, SQLContext, HiveContext (0) | 2020.03.15 |